Zawartość

15 października 2019 rJeśli szukasz smartfona z dobrym aparatem, nie ma wątpliwości, że widziałeś serię Pixel Google na liście rekomendacji. Z roku na rok Google wymyśliło, jak stworzyć aparat, który za każdym razem zapewnia doskonałe rezultaty. Od technologicznego blogera do podglądania pikseli po codziennego konsumenta, trudno jest znaleźć jedną osobę, która nie uwielbia kamer Pixela.

Tyle że Google nie próbuje tworzyć kamer. Stara się tworzyć magię.

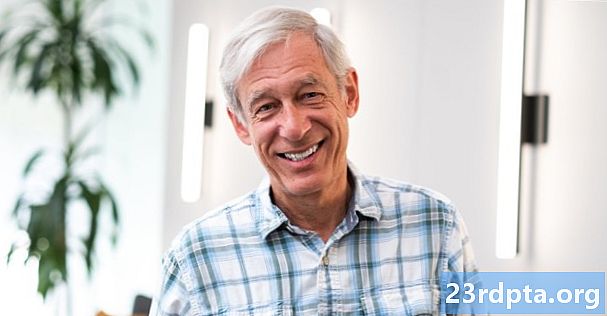

-

- Marc Levoy

-

- Isaac Reynolds

Niedawno miałem okazję usiąść z Markiem Levoyem i Izaakiem Reynoldsem - głównymi umysłami stojącymi za frustrująco dobrym systemem kamer serii Pixel. Rozmawialiśmy długo o nowych funkcjach aparatu Pixel 4, od ulepszonego Night Sight po jego WYSIWYG (What You See Is What You Get) HDR + wizjer w czasie rzeczywistym. Było wiele technicznych dyskusji na temat tego, w jaki sposób Google włącza te funkcje, ale pod koniec jedno stało się jasne. Aparat Google Pixel w ogóle nie polega na próbie bycia aparatem.

„Naszą podstawową filozofią jest budowanie kamery, która robi magię, która jest połączeniem prostoty i jakości obrazu”, wyjaśnił Reynolds, „Więc Night Sight wciąż tam jest, domyślnie HDR + nadal tam jest. Cały proces, który odbywa się pod maską, aby uzyskać świetne zdjęcie z trybu domyślnego, nadal istnieje. Wprowadziliśmy też znacznie więcej uproszczeń ”.

Tryb domyślny. Uproszczenie. Magia. Są to zwroty, których używa Google w ramach swojej podstawowej filozofii aparatu Pixel. W myślach Levoya i Reynolda uchwycenie chwili nie musi dotyczyć pokręteł trybu i menu ustawień.Google nie próbuje wbudować aparatu w swój telefon, próbuje zbudować coś, co sprawia, że niezmiennie wspaniałe zdjęcia wychodzą z bramki, tradycyjnymi środkami lub w inny sposób.

To co widzisz Jest Tym Co dostajesz

![]()

Jedną z nowych funkcji Pixela 4 jest wizjer WYSIWYG, co oznacza, że zobaczysz wyniki HDR + jeszcze przed zrobieniem zdjęcia. Może to wydawać się drobną funkcją, ale umożliwia pewne rzeczy, które po prostu nie są możliwe w aparatach nieobsługujących obliczeń.

Celem tego wizjera WYSIWYG jest maksymalne ograniczenie interakcji użytkownika. Pokazując powstały obraz zaraz po otwarciu aparatu, będziesz wiedział, czy natychmiast uzyskasz równomierną ekspozycję, i możesz po prostu skupić się na przybiciu ujęcia.

„Jeśli widzimy, że użytkownik puknął, wiemy, że kamera nie dawała mu tego, czego chcieli od samego początku”. Kontynuuje Reynolds, „Więc stuknięcie jest dla mnie potencjalnie przyczyną awarii, którą chcielibyśmy poprawić . ”

Tradycyjne systemy kamer bardzo źle radzą sobie z uzyskiwaniem żądanego obrazu bezpośrednio z aparatu. Możesz eksponować dla świateł i podnosić cienie później, lub wystawiać dla cieni, ale zdmuchnąć światła. Dzięki technologii możemy robić obie rzeczy i właśnie tam fotografia komputerowa naprawdę zaczyna sprawiać, że ta magia się dzieje.

„Posiadanie wizjera WYSIWYG oznacza, że możemy ponownie przemyśleć sposób kontrolowania ekspozycji w aparacie, jeśli chcesz”. Mówi Levoy: „Więc jeśli stukniesz, a zanim uzyskasz suwak kompensacji ekspozycji, otrzymasz teraz dwa suwaki. Nazywamy tę funkcję podwójną kontrolą ekspozycji. I mogą to być światła i cienie. Może to być jasność i zakres dynamiczny. Istnieje wiele sposobów wykonania tych dwóch zmiennych. Skonfigurowaliśmy go do robienia jasności i cieni. A to daje ci kontrolę, jakiej nikt wcześniej nie miał przed kamerą. ”

Edytujesz zdjęcie jeszcze przed zrobieniem zdjęcia.

Levoy ma rację. Kontrola podwójnej ekspozycji jest czymś, co można uzyskać jedynie za pomocą obrazowania komputerowego. Jako podstawa obraz będzie równy, z zachowanymi światłami i widocznymi cieniami. Ale jeśli chcesz, możesz indywidualnie regulować światła i cienie, zanim jeszcze zrobisz zdjęcie. To było coś, co wcześniej mogłeś zrobić tylko w oprogramowaniu do edycji zdjęć, po zrobieniu zdjęcia.

Zespół Levoy stara się ominąć ograniczenia tradycyjnego aparatu, koncentrując swoje wysiłki na ograniczeniach, jakie mają tradycyjne aparaty. Podczas gdy większość producentów wprowadza tryby Pro, aby dać ci kontrolę nad przysłoną, czasem otwarcia migawki i ISO, Google próbuje automatycznie zrobić lepszy obraz niż możesz, nawet jeśli masz odpowiednie pokrętła.

Zabij to dzięki nauce

![]()

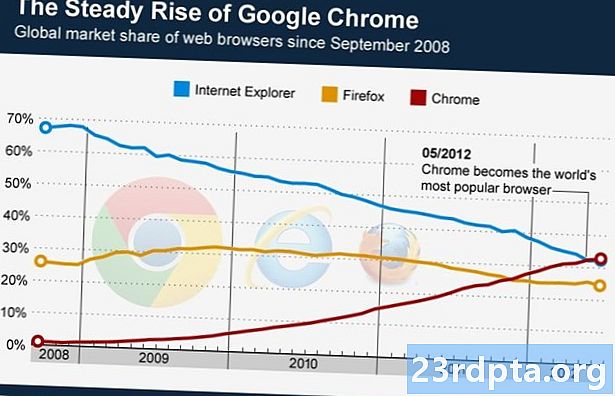

Jakie zatem sposoby obrazowania obliczeniowego mogą przewyższyć tradycyjne techniki kamer? W tym roku zespół Levoya walczy ze słabym światłem.

Pixel 4 wprowadza system balansu bieli oparty na uczeniu się. Ta funkcja działa w celu ciągłego ulepszania kolorów na zdjęciach, nawet w skrajnie słabym świetle. Google celuje w słabe i żółte światło i wykorzystał światło Sodium Vapor jako przykład czegoś, co próbuje naprawić, ale dąży do uzyskania idealnego balansu bieli za każdym razem.

Lampy sodowe są rodzajem lampy gazowej, która rzuca niemal monochromatyczny efekt na obiekty ze względu na niezwykle wąską długość fali od 589 nm do 589,3 nm. Są używane, ponieważ są bardzo wydajnym źródłem światła, więc często zobaczysz je w lampach ulicznych lub innych światłach, które muszą trwać długo. Jest to jedna z najtrudniejszych sytuacji, aby uzyskać dokładny balans bieli, więc poprawka oprogramowania Google jest naprawdę imponująca.

„Byłby żółty w przypadku światła pary sodowej, a my postaramy się zneutralizować to złe oświetlenie”, mówi Levoy. „Dzieje się dużo w słabszym świetle. Jeśli wejdziesz na dyskotekę i pojawią się czerwone neony, zachowa to, ale spróbuje zneutralizować niektóre niekorzystne oświetlenie obszarów. ”

Balans bieli oparty na uczeniu się był już obecny w trybie Google Night Sight, dlatego jego ostateczny obraz miał znacznie lepszy kolor niż coś takiego jak tryb automatyczny na Huawei P30 Pro. System uczy się na podstawie zdjęć zrobionych na urządzeniu, które uważa za dobrze wyważone, i wykorzystuje wyuczone dane do tworzenia bardziej dokładnych kolorów w słabo oświetlonych warunkach. Jest to coś, czego tradycyjne systemy kamer po prostu nie mogą zrobić. Po dostarczeniu aparatu automatyczny balans bieli to automatyczny balans bieli. W Pixel z czasem zawsze działa się lepiej.

Balans bieli oparty na uczeniu się sprawia, że świetne zdjęcia przy słabym świetle są jeszcze łatwiejsze, ale Levoy chce użyć komputerów, aby uprościć trudną niegdyś formę obrazowania - astrofotografię.

Spójrz w gwiazdy

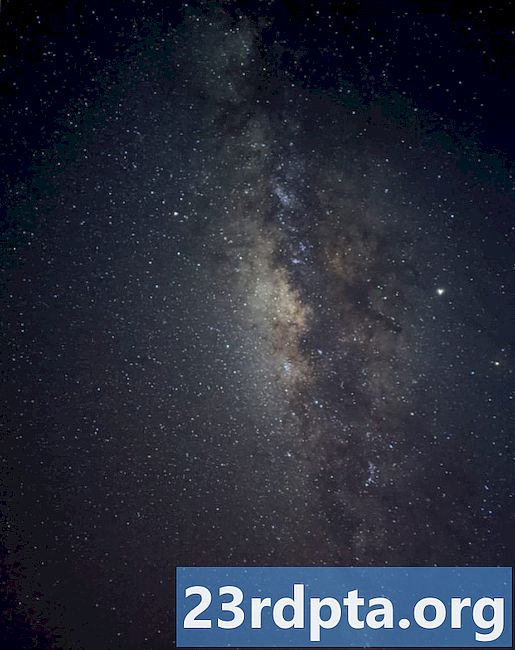

Źródło: Google

Levoy nazywa tę nową funkcję „HDR + na sterydach”. Tam, gdzie standardowa HDR + wykonuje serię 10-15 krótkich ekspozycji, wyrównuje je i uśrednia, aby uzyskać ostre zdjęcia z niskim poziomem szumów, ten nowy tryb zajmuje do 15 zestawów 16-sekundowych ekspozycji, aby stworzyć 4-minutową ekspozycję. Następnie system wyrównuje obrazy (ponieważ gwiazdy poruszają się w czasie) i dostosowuje odpowiednie ustawienia, jednocześnie redukując szum za pomocą średnich pikseli, aby stworzyć zdumiewające obrazy.

To był dla mnie rodzaj Świętego Graala.

Marc LevoyLevoy pokazał mi kilka zdjęć, które jego zespół zrobił z mlecznej drogi, a moja szczęka dosłownie opadła. Chociaż możliwe jest wykonywanie długich ekspozycji na tradycyjnych systemach kamer, zwykle potrzebujesz dodatkowego sprzętu, aby obrócić aparat z czasem, jeśli chcesz uzyskać wyjątkowo ostre zdjęcia. Dzięki Night Sight możesz po prostu oprzeć telefon o skałę, nacisnąć migawkę, a urządzenie zajmie się resztą.

Być może najmądrzejszą częścią tego nowego trybu Astro Night Sight jest to, że wcale nie jest to osobny tryb. Wszystko dzieje się z przyciskiem Night Sight. HDR + już wykorzystuje żyroskop do wykrywania ruchu i wyrównywania serii zdjęć, a Night Sight wykryje teraz, jak długo można zrobić zdjęcie w zależności od tego, jak stabilne jest urządzenie po naciśnięciu spustu migawki, do czterech minut. Wykrywa także niebo za pomocą metody zwanej segmentacją semantyczną, która pozwala systemowi traktować niektóre obszary obrazu inaczej, aby uzyskać najlepszy wynik.

-

- Źródło: Google

-

- Źródło: Google

„Chcemy, aby wszystko było łatwe w użyciu”, mówi Reynolds, „więc za każdym razem, gdy znajdziemy w produkcie coś, co nie musi tam być, możemy odebrać Ci tę odpowiedzialność i rozwiązać to za Ciebie”.

To stwierdzenie naprawdę sprowadza się do tego, co Google próbuje zrobić z aparatem Pixela. Zamiast zastanowić się, jak sprawić, by działał jak kamera, Google próbuje rozwiązać problemy, o których istnieniu nawet nie wiedziałeś, i przedstawić je w najprostszej możliwej formie.

Oczywiście obie strony mają zalety. Niektórzy ludzie mogą chcieć aparat telefoniczny, który działa jak aparat, z ręcznymi elementami sterującymi i pokrętłami. Mogą chcieć większe czujniki i tryby Pro. Ale podczas gdy inne ODM koncentrują się prawie wyłącznie na sprzęcie, Google patrzy w zupełnie innym kierunku.

Chce magii.

Chcesz dowiedzieć się więcej o fotografii obliczeniowej? Sprawdź powyższy film, aby zobaczyć, jak to pole zmieni sposób, w jaki tworzymy obrazy.

Pixel 4